Was Staaten gegen Desinformationskampagnen tun

Wie Staaten gegen Desinformation vorgehen können

Künstliche Intelligenz und immer bessere Algorithmen treiben die Verbreitung von falschen Nachrichten im Superwahljahr 2024 voran

Von Gesche Wüpper, Paris

Ein manipuliertes Video der Tagesschau, in dem ein willkürlich zusammengeschnittenes Interview den Eindruck vermittelt, öffentlich-rechtliche Medien in Deutschland hetzten gegen Opposition und Minderheiten. Eine mithilfe von künstlicher Intelligenz erstellte Aufnahme, die die Stimme eines proeuropäischen slowakischen Politikers nachahmt und ihm Aussagen in den Mund legt, wie er die Stimmen von Wählern manipulieren will.

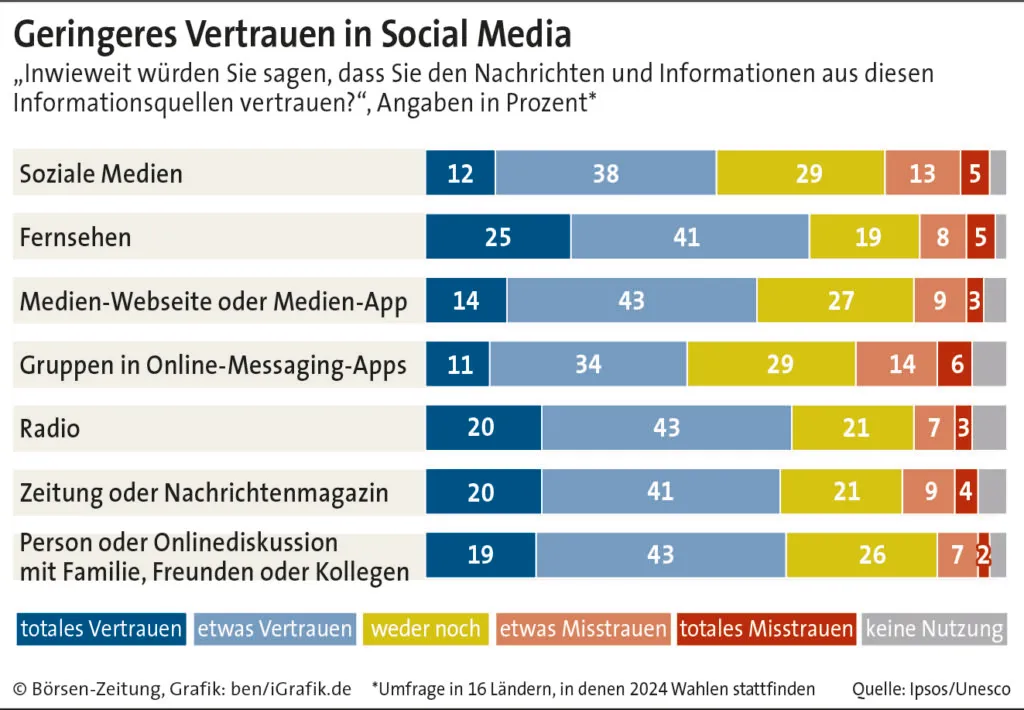

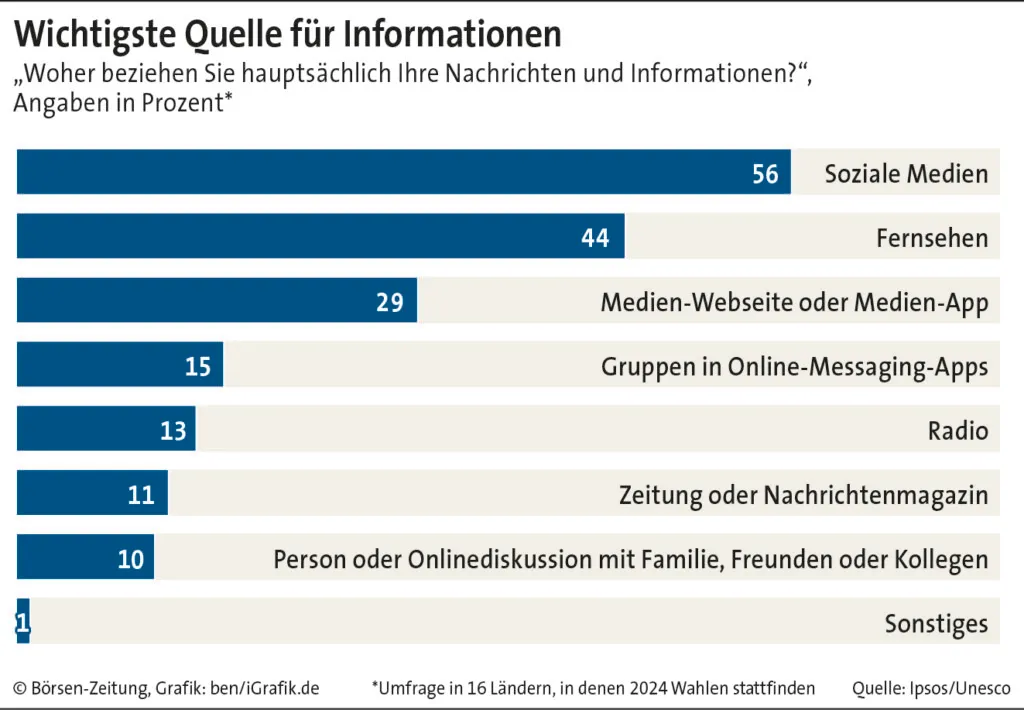

KI und immer bessere Algorithmen verändern nicht nur die Art, wie Informationen produziert, geteilt und konsumiert werden. Sie machen es auch immer schwieriger, authentische Inhalte von gefälschten zu unterscheiden. Im Superwahljahr 2024, in dem die Hälfte der globalen Bevölkerung wählen soll, ist das von entscheidender Bedeutung – zumal inzwischen Soziale Medien die am stärksten genutzte Informationsquelle sind. Gezielte Desinformationskampagnen können nicht nur weitreichende Konsequenzen für Wahlen, sondern auch für viele andere Bereiche haben, von der nationalen Sicherheit über das Gesundheitswesen bis zur Privatwirtschaft.

Bots geben Takt vor

Institutionen und Regierungen, aber auch Unternehmen wie Google beschäftigen sich deshalb verstärkt mit dem Thema. Die Organisation für wirtschaftliche Zusammenarbeit und Entwicklung (OECD) hat kürzlich einen 141 Seiten langen Bericht veröffentlicht, wie Gesellschaften mit Desinformationen umgehen und die Informationsintegrität stärken können. Darin analysiert sie auch, welche Maßnahmen einzelne Länder bereits ergriffen haben – damit andere Staaten davon lernen können.

„Keine Demokratie kann das Problem des Anstieges von Desinformationen allein lösen“, ist OECD-Generalsekretär Mathias Cormann überzeugt. Deshalb plädiert er für eine stärkere internationale Zusammenarbeit auf dem Gebiet. Gleichzeitig warnt er davor, aus Angst vor Desinformationskampagnen Medien immer stärker regulieren zu wollen. „Der Kampf gegen Desinformationen darf niemals die Form einer Kontrolle der Informationen annehmen“, sagt er.

Allerdings wird die Wirkung von Desinformationen, die mittels generativer KI erzeugt wurden, mittlerweile durch den Einsatz von Algorithmen und Robotern, den sogenannten Bots, zusätzlich verstärkt. Damit können falsche Nachrichten zu geringen Kosten schnell unter sehr vielen Nutzern verbreitet werden. Wichtig sei deshalb, über die von traditionellen Medien in der Regel angewandte Selbstkontrolle hinauszugehen, rät Elsa Pilichowski, die Direktorin für Public Governance bei der OECD. Das gelte vor allem für Soziale Medien. Alle Plattformen, die Informationen verbreiten, müssten dafür mehr Verantwortung übernehmen, empfiehlt sie. Damit ihre kommerziellen Interessen nicht zur massiven Verbreitung von Fake News beitragen, hält die OECD neben mehr Verantwortung mehr Transparenz für notwendig.

Ein Beispiel, wie das gehen kann, ist ein 2019 in Kalifornien in Kraft getretenes Gesetz, der Bolstering Online Transparency Act. Dieser verpflichtet Bots, ihre Identität im Netz offenzulegen. Um Fake News besser bekämpfen zu können, sei es zudem wichtig zu verstehen, wie Algorithmen erstellt werden, meinen Experten. Denn bis heute sei nicht bekannt, welchen Effekt diese hätten, erklärt Oana Goga. Sie leitet für das französische Forschungszentrum Centre national de la recherche scientifique (CNRS) das Informatiklabor an der École Polytechnique und erforscht dort die Risiken von Online-Plattformen und KI für Individuen und Gesellschaften. „Wir müssen uns eher auf den Prozess der Herstellung von falschen Informationen konzentrieren als auf ihren Inhalt“, sagt sie.

Helfen, sich gegen ausländische digitale Einflussnahmen zu schützen, soll auch der 2021 in Frankreich ins Leben gerufene staatliche Dienst Viginum. Er analysiert öffentliche Online-Inhalte. Erst jüngst hatte er herausgefunden, dass ein Netz von mindestens 193 Informationsportalen in europäischen Ländern sowie den USA prorussische, irreführende oder unrichtige Informationen verbreitet. Diese werden von den Portalen nicht selber erstellt, sondern von Konten auf Sozialen Medien, russischen Presseagenturen und offiziellen Stellen bezogen.

Riesiges Bot-Netz ausgehoben

Quasi als Folge dieser Erkenntnisse debattiert die französische Nationalversammlung jetzt einen Gesetzentwurf, der vom amerikanischen Foreign Agents Registration Act (FARA) inspiriert ist. Damit sollen ausländische Akteure, die das öffentliche Leben in Frankreich beeinflussen, gezwungen werden, sich zu registrieren und Ethikregeln einzuhalten. Die linkspopulistische Oppositionspartei La France Insoumise will das Gesetz jedoch verhindern.

David Colon vom Institut des Sciences Politiques empfiehlt, vor allem die Bevölkerung zu sensibilisieren. Obwohl gerade die junge Generation Vertrauen in offizielle Institutionen verliere, sei Medienerziehung unterfinanziert, unterbewertet und zu wenig verbreitet, kritisiert er. Colon rät, sich an Finnland zu orientieren, wo Medienbildung seit den fünfziger Jahren auf dem Stundenplan steht. Im Rahmen des Pflichtfachs beschäftigen sich finnische Schüler inzwischen intensiv mit Desinformationskampagnen.

Um das Verständnis zu erhöhen, wie Desinformationen verbreitet werden, haben Forscher des Social Decision-Making Laboratory der University of Cambridge mit dem Médialab von Sciences Po, unterstützt von Großbritannien und der Weltgesundheitsorganisation, das Online-Spiel „Go Viral!“ entwickelt. Es simuliert ein Umfeld in Sozialen Medien und setzt die Spieler gängigen Manipulationstechniken aus. Schweden wiederum hat 2022 die Swedish Psychological Defence Agen-

cy gegründet. Sie identifiziert, analysiert und kontert ausländische Beeinflussungskampagnen, die sich gegen die Landesinteressen richten. Auch das soll die Sensibilität der Bevölkerung steigern.